¿Podemos confiar en las decisiones sugeridas por algoritmos de inteligencia artificial?

Los algoritmos inteligentes de aprendizaje automático (machine learning) son capaces de aprender de un histórico de datos y producir un modelo de conocimiento mediante la optimización de una función de interés. Si un modelo generado de este modo funciona bien, ¿por qué no simplemente confiar en el modelo e ignorar por qué éste sugirió tomar una determinada decisión? El problema de hacerlo radica en que una sola métrica a optimizar por un algoritmo, tal como la tasa de acierto o el error de predicción, supone una descripción incompleta de la mayoría de los problemas del mundo real y los resultados obtenidos podrían no ser verosímiles.

La interpretabilidad de un modelo de aprendizaje automático permite conocer su funcionamiento interno y explicar los motivos por los que éste sugiere tomar determinadas decisiones. Cuando hacemos modelado predictivo, debemos preguntarnos: ¿queremos simplemente saber qué se predice? Por ejemplo, la probabilidad de que un cliente se vaya de una compañía o cuán efectivo será algún medicamento para un paciente. ¿O deseamos saber por qué hizo la predicción y, posiblemente, sacrificar la precisión del algoritmo por interpretabilidad?

En algunos casos, podría no importarnos por qué la máquina sugirió tomar una decisión, solo es suficiente la seguridad de que el rendimiento predictivo de la máquina fue bueno en un conjunto de datos de prueba (por ejemplo, en entornos de bajo riesgo, como los sistemas de recomendación de películas). En otros casos, conocer el por qué puede ayudarnos a comprender más sobre el problema y por qué podría fallar el modelo aprendido por la máquina.

La necesidad de interpretabilidad de los modelos proviene de una incompletitud en la formalización del problema que se pretende resolver, lo que significa que para ciertos problemas o tareas no es suficiente obtener la respuesta del modelo. El modelo también debe proporcionarnos una explicación de cómo llegó a su respuesta, porque una predicción correcta solo resuelve parcialmente el problema original.

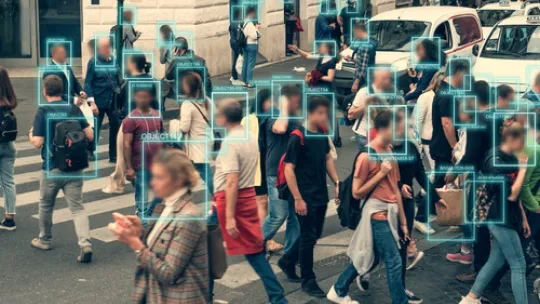

Se acabó la confianza ciega, la inteligencia artificial debe explicar cómo funciona

Las razones que actualmente impulsan la demanda de interpretabilidad de modelos de inteligencia artificial son la curiosidad y el aprendizaje humano. Las personas poseemos un modelo mental de nuestro entorno que se actualiza cuando sucede algo inesperado y se encuentra una explicación para dicho suceso. Si no hay explicación, no hay aprendizaje. La curiosidad y el aprendizaje son importantes en investigación, donde los hallazgos científicos deben ser explicados e interpretados. Además, en el ámbito de la medicina, existe regulación europea para la interpretabilidad de modelos de inteligencia artificial.

Fundamentalmente existen dos tipos de modelos: los modelos de caja blanca y los de caja negra. Los modelos de caja blanca, por ejemplo, los árboles de decisión o la regresión lineal, ofrecen una representación del conocimiento fácil de interpretar. Por el contrario, los modelos de caja negra, por ejemplo, las redes neuronales, no ofrecen dicha facilidad de interpretación.

En el Máster de Inteligencia Artificial de la Universidad Internacional de Valencia, estudiamos tanto algoritmos de aprendizaje automático de caja blanca como de caja negra. Para los primeros, la interpretabilidad está asegurada por la propia construcción del modelo. Para los segundos, por ejemplo, las redes neuronales y Deep Learning, existen numerosas librerías que permiten extraer una explicación automática de dichos modelos. Por ejemplo, LIME, SHAP, ELI5 y DALEX, entre otras. Además, las tres primeras usan el lenguaje de programación Python, el cual también estudiamos en el Máster de Inteligencia Artificial de la Universidad Internacional de Valencia, con lo que podemos usarlas directamente sobre nuestros modelos y conseguir entender cómo funcionan interiormente.